Comment tester si une URL est bloquée au crawl dans Google Sheets ?

Table des matières

Google Sheets est un outil que j'utilise tous les jours pour réaliser tout un tas d'opérations : analyse de données chiffrées, scraping de contenu, comptage de caractères, connexion à des API, etc.

Aujourd'hui, voyons ensemble comment vérifier, avec Google Sheets, si une URL est bloquée par le robots.txt.

Pour faire cela, on va utiliser une technique de sioux.

1ère étape : trouver un outil en ligne de test de robots.txt

Des outils de ce type, il en existe plein.

Celui que j'ai retenu, c'est celui-ci : https://en.ryte.com/free-tools/robots-txt/.

Pourquoi ? Car les données de son formulaire sont envoyées avec la méthode GET, donc visibles dans l'URL.

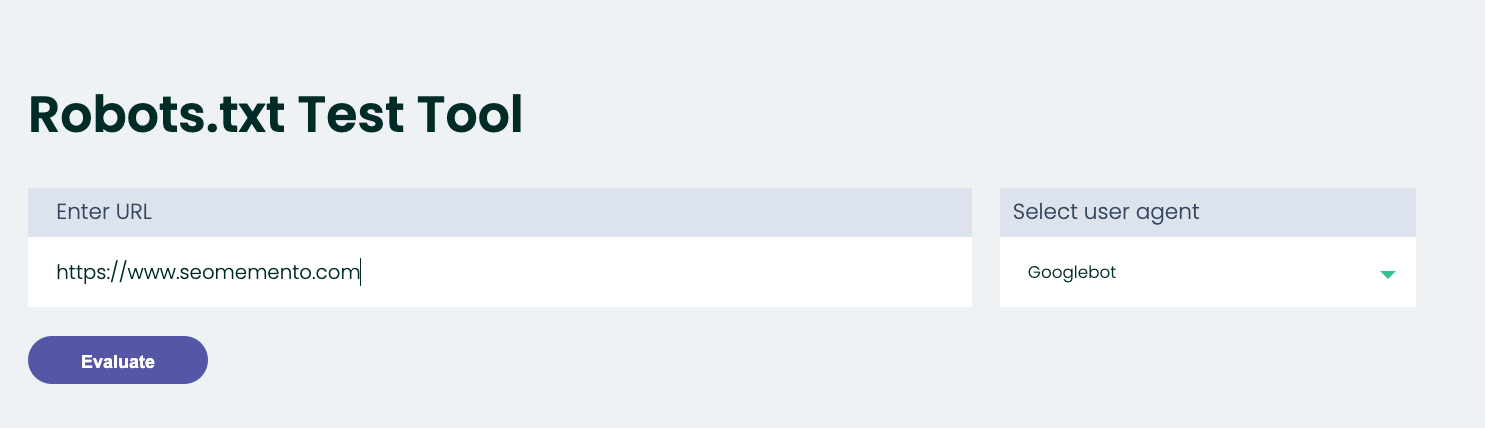

En soumettant le formulaire, on arrive en effet sur la page suivante : https://en.ryte.com/free-tools/robots-txt/?refresh=1&url=https%3A%2F%2Fwww.seomemento.com&useragent=Googlebot&submit=Evaluate.

2 paramètres d'URL sont ici particulièrement intéressants :

- url : l'URL à tester

- useragent : le robot d'exploration auquel les règles doivent s'appliquer

On va donc pouvoir manipuler ces paramètres pour tester différentes URLs, selon différentes configurations d'user-agent, directement dans Google Sheets.

2ème étape : automatiser la récupération du résultat dans Google Sheets

Voici comment procéder dans ta feuille Google Sheets :

- Entre l'URL à tester dans une colonne, par exemple en A1

- Entre le user-agent de ton choix dans une deuxième colonne, par exemple en B1. Les différentes valeurs acceptées par l'outil de Ryte sont :

- Googlebot

- Googlebot-Image

- MSNBot

- Slurp

- Lycos

- Seekbot

- Sistrix

- SearchmetricsBot

- BacklinkCrawler

- SEOkicks

- Xovi

- Entre la formule suivante dans une troisième colonne, par exemple en C1

=IMPORTXML("https://en.ryte.com/free-tools/robots-txt/?refresh=1&url="&ENCODEURL(A1)&"&useragent="&B1&"&submit=Evaluate";"//p[@class='white_block']/strong[1]")

Cette formule utilise la fonction IMPORTXML de Google Sheets.

Le premier paramètre est l'URL de la page d'où extraire le contenu. Pour "dynamiser" cette URL, on va simplement concaténer l'URL (en l'encodant au préalable via la fonction ENCODEURL) et la chaîne de caractères correspondant au user-agent choisi.

Le deuxième paramètre est le xpath suivant :

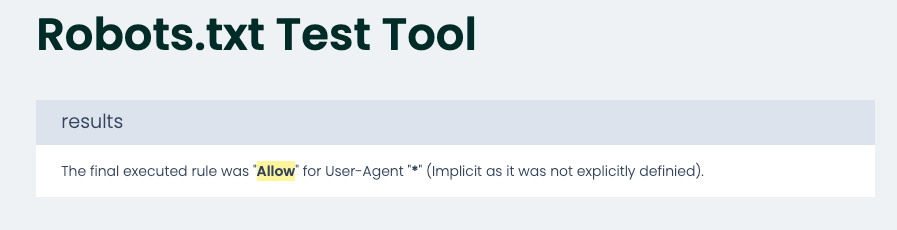

//p[@class='white_block']/strong[1]Dans la page, cela correspond à la règle trouvée pour l'URL testée (ici "Allow").

Et voilà, il n'y a plus qu'à laisser la magie opérer.

- Partager sur Twitter

- Partager sur Facebook

- Partager sur LinkedIn

- Partager sur Pinterest

- Partager par E-mail

- Copier le lien

Un Template Google Sheets Offert ! 🎁

Rejoins ma newsletter et reçois une astuce SEO chaque mercredi ! En cadeau, je t'offre un template Google Sheets avec 50 fonctions de scraping prêtes à l'emploi.